深度学习为何需要GPU及显卡详细解析

说在前面

深度学习改变了许多领域,为图像识别、自然语言处理和自动驾驶等现代技术提供了强有力的支持。然而,对于那些初次进入这一领域的人来说,可能会遇到一个常见的问题:为什么深度学习对GPU(图形处理单元)的需求如此迫切?本文将深入探讨这一问题,解释GPU在深度学习中的重要性,并帮助你更好地理解和应用GPU进行深度学习项目。

在本文中,我们将介绍GPU的基本概念及其发展历程,通过具体实例解析深度学习为何需要GPU。接着,我们会提供一些有用的技巧,并解答一些常见问题,帮助读者更清晰地掌握这一主题。

GPU及显卡的背景介绍

定义和基本概念

GPU,全称图形处理单元(Graphics Processing Unit),最初被设计用于图像渲染和2D、3D图形处理。其核心优势在于具备高度并行计算能力,能够同时处理大量数据。这使得GPU不仅适用于图像处理,也同样适合深度学习中大量矩阵运算和并行计算任务。

显卡(Graphics Card),则是物理上包含GPU的硬件设备,通常还包括显存、冷却装置等组件,以便在各种计算设备中广泛使用。

历史和发展

最早的GPU可以追溯到1980年代,当时它们主要用于游戏和图形渲染。随着计算能力的提高,20世纪90年代末,GPU开始具备更高的计算性能,也逐渐应用于科学计算和金融建模等领域。

进入21世纪,深度学习的发展催生了对更高性能计算的需求。NVIDIA等厂商推出了针对深度学习优化的GPU和相关SDK(如CUDA、cuDNN),极大地提升了深度学习模型训练效果。随之而来的还有AI专用加速芯片(如TPU),进一步推动了人工智能的发展和应用。

深度学习为何需要GPU

并行计算优势

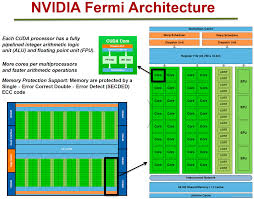

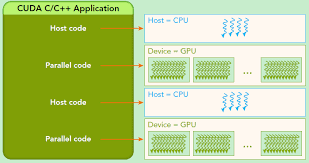

GPU在深度学习中的一个重要作用就是并行计算。深度学习大量涉及矩阵乘法、卷积操作等计算密集型任务,而这些任务都可以通过并行化来显著加速。与CPU(中央处理单元)相比,GPU有数千个小型处理单元,能够同时处理大量数据,从而降低模型训练的时间。

“现代GPU采用了统一着色器架构,实现了多核并行和SIMT(单指令多线程)技术,能够高效地执行并行计算任务。” —《深度学习中的GPU与显存关键解析》

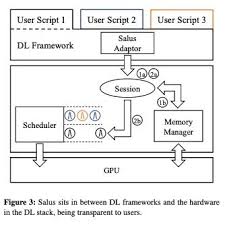

优化深度学习库

深度学习框架如TensorFlow、PyTorch等,都经过GPU优化,使得使用GPU进行模型训练变得更加简单高效。通过使用NVIDIA的CUDA和cuDNN库,这些框架能够充分利用GPU的并行计算能力,提高计算效率。

同时,GPU驱动的不断更新和优化,也为深度学习领域提供了越来越多的便捷工具和优化方法。

缩短模型训练时间

对于复杂的深度学习模型,训练时间往往从数小时到数星期不等。如果使用传统的CPU,训练时间可能会更加漫长。然而,引入GPU后,得益于其强大的并行计算能力,可以将训练时间缩短1-2个数量级。这对于实验迭代和模型更新来说,显著增强了效率。

CUDA和Tensor核心的贡献

CUDA(Compute Unified Device Architecture)是一种由NVIDIA推出的并行计算平台和编程模型,允许开发者使用C、C++等高层编程语言编写程序,直接在NVIDIA GPU上运行。

Tensor核心,专为深度学习设计,进一步提升了深度学习模型涉及的大规模矩阵乘法的计算效率。在最新的NVIDIA GPU中,Tensor核心提供了极高的浮点运算能力,使复杂的深度学习任务在运行效率方面有了质的飞跃。

深度学习相关Tips

- 选择合适的GPU:根据项目需求和预算选择适合的GPU,如NVIDIA的GeForce系列适合个人开发者,Tesla系列适合企业级应用。

- 优化代码和模型:使用深度学习框架中的优化工具和库(如cuDNN和TensorRT)来提升模型训练和推理效率。

- 定期更新驱动:保持GPU驱动和相关软件的更新,确保获得最新的性能优化和功能支持。

- 使用云GPU服务:如果预算有限,可以选择使用云服务提供的GPU资源,如AWS、Google云平台等,按需支付费用。

- 注意散热和电源管理:高强度的计算任务会使GPU发热严重,需配备良好的散热系统。同时,要确保电源供给充足,避免因功耗不足导致的计算中断。

深度学习常见问题解答(FAQ)

-

Q: 深度学习是否必须使用GPU?

A: 并不一定必须使用,但GPU能显著缩短训练时间。如果不用GPU,训练复杂模型可能需要数倍的时间。 -

Q: GPU和TPU有什么区别?

A: GPU主要由NVIDIA生产,专为图形和并行计算设计。TPU(Tensor Processing Unit)则由Google开发,专为加速机器学习任务设计。两者在性能和用途上各有优势。 -

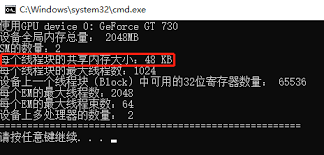

Q: 什么是显存?深度学习对显存要求高吗?

A: 显存(Video RAM)是GPU上的专用内存,用于存储正在处理的数据。深度学习模型通常需要大量显存来存储和处理模型参数,较大的显存能够支持更复杂和更大规模的模型。 -

Q: 如何选择适合的深度学习显卡?

A: 根据预算和需求选择显卡。如NVIDIA的RTX系列适合个人和小型团队,Tesla系列适合高性能计算和企业应用。可以参考显卡性能和显存大小。 -

Q: 深度学习对GPU的品牌有要求吗?

A: 不同品牌的GPU在性能和优化上存在差异,但主流的深度学习框架多为NVIDIA的CUDA和cuDNN优化,因此NVIDIA的GPU通常是首选。

总结

总的来说,GPU在深度学习中的重要性不可忽视。借助GPU强大的并行计算能力和相关优化,在深度学习项目中能显著提升效率和性能。选择合适的GPU,并合理利用深度学习框架中的优化工具,将有助于更快、更高效地完成深度学习任务。

读者可根据自己的项目需求和预算选择适合的GPU,并参考本文中的提示和常见问题解答,进一步优化自己的深度学习项目。探索和应用GPU技术,将为你的深度学习项目带来新的突破和可能性。