了解GPT-4与GPT-3.5的Token数量与限制,详解GPT-4 Token价格与长度

在这篇文章中,我们将深入探讨GPT-4与GPT-3.5的Token数量与限制,特别是GPT-4在Token长度、数量以及价格方面的信息。通过全面解读这些内容,您将了解如何突破GPT-4的Token上限,并更好地优化Token使用,以发挥其强大功能。

背景介绍

人工智能语言模型已经在多个领域产生了深远的影响。OpenAI的GPT(生成式预训练模型)系列模型是其中的佼佼者,从GPT-3到GPT-4,每一代模型都在能力和复杂度上有显著提升。在这些模型中,Token的使用和限制是一个重要的话题,直接影响到模型的应用场景和效果。

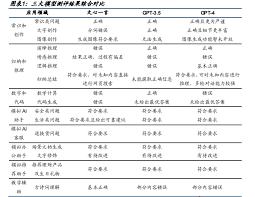

GPT-3.5与GPT-4的Token数量与限制

Token的定义和基本概念

Token是语言模型处理文本的基本单位,可以是一个词、一个子词甚至一个字符。在自然语言处理中,Token数量越多,模型所能处理的上下文就越复杂和详细。

GPT-3.5的Token限制

GPT-3.5模型的最大Token限制是4096个。这意味着在单次交互中,模型最多可以处理4096个Token,包括输入和输出。这一限制适用于广泛的应用场景,但在需要处理更长文本时可能显得不足。

GPT-4的Token限制

相比之下,GPT-4在Token数量上有了显著提升。基础版的GPT-4模型最大Token数为8192个,而增强版GPT-4-32K能够处理多达32768个Token。最近推出的GPT-4 Turbo版本甚至支持到128K个Token,极大提升了处理长文本的能力。

价格方面的考量

使用GPT模型的一项重要成本是Token的计费。GPT-4的Token价格通常高于GPT-3.5,但其强大的性能和更大的Token上下文长度使其在许多高要求场景中具有明显优势。

- GPT-3.5的Token价格相对低廉,适用于较简单的任务和日常对话。

- GPT-4基础版的Token价格较高,但其性能更强,适用于复杂任务。

- GPT-4 Turbo提供了一个折中的选择,有更高Token限制的同时价格较为友好。

突破GPT-4 Token限制的小贴士

在实际应用中,Token限制可能成为一些项目的瓶颈。以下是一些优化Token使用的方法:

- 预处理文本:使用数据清洗技术去掉冗余信息,减少Token数量。

- Token压缩:通过缩写或者同义词替代来减少Token使用。

- 分段处理:将长文本分段处理,再将结果合并。

- 选择合适的模型:根据任务复杂度选择GPT-4 Turbo等具有高Token上限但相对便宜的版本。

常见问题解答

GPT模型对Token的定义是什么?

GPT的Token是用于处理文本的基本单位,包括词、词缀、字符等。

GPT-4的Token价格是多少?

具体价格根据使用版本不同而异,通常基础版价格较高,Turbo版相对便宜。

如何突破GPT-4的Token限制?

可以通过预处理文本、Token压缩、分段处理等方法来优化Token使用。

GPT-4可以处理多长的文本?

基础版可处理8192个Token,增强版和Turbo版的Token上限更高。

总结

本文详细探讨了GPT-4与GPT-3.5的Token数量与限制,从Token的定义到价格方面的考量。通过了解这些内容,您可以更好地优化GPT系列模型的使用,特别是在需要处理长文本和复杂任务时。GPT-4的高Token上限与强大功能相结合,使其成为解决复杂自然语言处理任务的理想选择。希望本文能帮助您更好地理解并应用这些语言模型,突破Token限制,充分发挥它们的潜力。