OpenAI Max Tokens参数详解:默认值、限制、Python和不同模型的最大Token配置

说在前面

大家好,今天我们要深入探讨的是 OpenAI Max Tokens 参数。这是一篇既深入又实用的文章,旨在为那些使用OpenAI API进行文本生成的开发者们提供一个详细的指南。通过本文,您将了解默认值、限制、Python 中使用该参数以及不同模型的最大Token配置。这对于您优化API调用并充分利用OpenAI的功能至关重要。

在本文中,我们将从定义和基本概念入手,逐步深入带您了解Max Tokens参数的应用和最佳实践。这里还有一份丰富的FAQ部分,希望能解答您在使用过程中遇到的各种疑惑。

预期内容概述: 我们首先会介绍一些基本术语和概念,然后深入探讨不同模型的最大Token配置及其具体应用,最后提供一些使用技巧和常见问题的解答。

背景介绍

Max Tokens参数的定义和基本概念: 在OpenAI的API中,Max Tokens 参数用于限制模型生成的最大Token数量。Token是语言模型用来处理文本的基本单位,通常一个Token可以是一个单词或某个单词的一部分。Max Tokens参数不仅影响生成的文本长度,还关系到请求的成本。

历史和发展: 自OpenAI推出文本生成模型以来,Max Tokens参数就一直是其关键配置之一。在GPT-3模型以及后续的GPT-4等更高级模型中,Max Tokens 参数的设置直接影响到生成内容的丰富度和完整性。随着技术的进步,各种模型的最大Token限制也在不断提升,以满足越来越复杂的应用需求。

OpenAI Max Tokens参数详细解读

默认值与应用

在OpenAI的API调用中,Max Tokens参数的默认值通常是16。这意味着模型会生成最多16个Token的文本。当然,根据不同的使用场景和需求,这个值可以被显著调整。

- 基本设定: 默认情况下,API调用会生成不超过16个Token的回答,但这个值可以根据需要进行调整。

- 上下文长度: 提示文本的Token数加上Max Tokens的总数不能超过模型的上下文长度。例如,大多数模型的上下文长度为2048个Token。

不同模型的最大Token配置

不同的OpenAI模型具备不同的最大Token限制,从较早期的GPT-3到最新的GPT-4,这些限制随着模型性能的提升而逐步增加。

GPT-3: 默认的上下文长度为2048个Token,这是模型处理输入及生成输出的组合数量。

GPT-3.5/3.5-turbo: 此版本对上下文长度进行了优化,一些版本支持到4096个Token。

GPT-4: 作为最新的版本,GPT-4的上下文长度可以达到8000个Token,甚至有些配置可以支持更高的长度。这使得处理更复杂和长文本成为可能。

在Python中使用Max Tokens参数

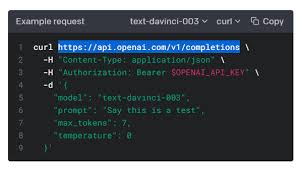

在Python中调用OpenAI API时,设置Max Tokens参数非常简单。以下是一个示例代码片段,展示了如何在API调用中应用这个参数:

import openai

openai.api_key = 'your-api-key'

response = openai.Completion.create(

engine="text-davinci-003",

prompt="请生成一个关于OpenAI Max Tokens 参数的简短介绍。",

max_tokens=50

)

print(response.choices[0].text.strip())

[插图: OpenAI Python代码示例]

在这个示例中,Max Tokens被设置为50,这意味着生成的文本不会超过50个Token。

相关Tips

- 合理设置Max Tokens: 根据任务需求调整Max Tokens值,避免生成过多冗余信息。

- 监控API使用成本: 每个Token都关系到成本,所以合理设置Max Tokens可以有效控制API调用的费用。

- 结合上下文长度使用: 确保提示文本和生成Token的总长度在模型的上下文长度限制内。

- 迭代测试: 通过多次测试和调整,找到最适合您具体应用场景的Max Tokens值。

- 使用部分生成: 对于较长的文本,可以分段生成,并结合后处理拼接。

常见问题解答(FAQ)

1. 什么是Token?

Token是模型处理文本的最小单位,可以是一个单词或部分单词。例如,“Hello, world!” 这个短语可能会被模型分解为[“Hello”, “,”, “world”, “!”]四个Token。

2. 怎么判断Max Tokens值需要设置多少?

这取决于您的具体应用。对于较短的回答,可以使用较小的值;对于需要更多详细信息的生成任务,可以适当增加。例如,用于对话生成时,您可能希望限制在200-300 tokens,而生成长篇文章时,可以增加到1000 tokens以上。

3. 超过Max Tokens会发生什么?

当生成的文本超过Max Tokens限制时,模型将停止生成,返回截至到Token限制为止的文本片段。

4. 如何结合API其他参数使用Max Tokens?

您可以通过结合使用Temperature、Top-p等参数来优化生成效果。例如,调低Temperature值可以让模型生成更有确定性的回答,同时通过设置适当的Max Tokens来控制生成文本的长度。

5. 当文本生成不完整时怎么办?

如果生成文本不完整,您可以参考生成的最后几句话作为新的提示,重新调用API进行继续生成,确保文本连贯性。

总结

通过本文,我们详尽解读了OpenAI Max Tokens参数的定义、不同模型的最大Token配置及在Python中的实际应用。在理解了这些概念后,希望各位能够更好地利用OpenAI API,优化文本生成效果。而且,通过掌握一些实用的小技巧,您可以有效地控制生成内容并避免不必要的成本浪费。

Max Tokens不仅是一个简单的参数,更是您使用OpenAI模型时的一个重要调优手段。希望这篇文章成为您处理OpenAI API任务的有力工具,继续探索生成式AI的无限可能吧!